DStream是什么?怎样对DStream进行操作?

更新时间:2021年12月27日11时41分 来源:传智教育 浏览次数:

DStream的本质

DStream(Discretized Stream)是Spark Streaming提供的基本数据抽象。它表示一个连续的数据流,可以是从源接收到的输入数据流,也可以是通过转换输入流生成的已处理数据流。

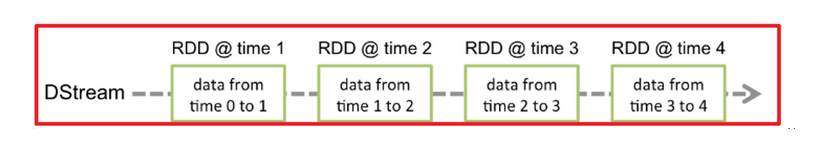

DStream由一系列连续的RDD表示,每个RDD都包含来自特定间隔的数据,如下图所示。SparkStreaming对流数据按照秒/分等时间间隔进行微批划分,每个微批就是一个RDD,这些个时间上连续的RDD就组成了

DStream

所以DStream本质上就是一系列时间上连续的RDD即DStream=>Seq[RDD]

对DStream进行操作

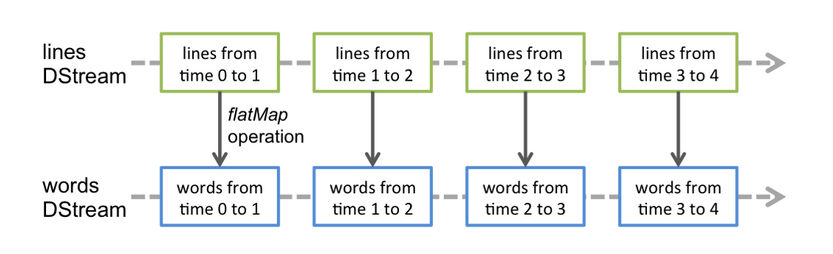

对DStream进行操作(如:flatMap/map/filter..)就是对其底层的RDD进行操作

对RDD操作会返回新的RDD,对DStream进行操作也会返回新的DStream

DStream具有容错性:

RDD之间存在依赖关系,DStream间也有依赖关系,RDD具有容错性,那么DStream也具有容错性

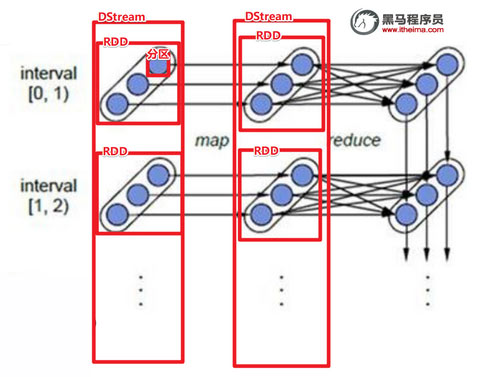

上图相关说明:

1、每一个椭圆形表示一个RDD

2、椭圆形中的每个圆形代表一个RDD中的一个Partition分区

3、每一列的多个RDD表示一个DStream(图中有三列所以有三个DStream

4、每一行最后一个RDD则表示每一个Batch Size所产生的中间结果RDD

DStream的API

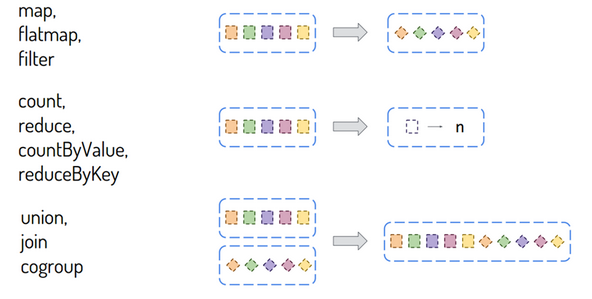

大多数Transformation和Action/Output和之前的RDD的一样使用.少部分不一样的通过案例讲解

DStream Operations

Transformation大多数和RDD中的类似,但有一些特殊的针对特定类型应用使用的函数,比如updateStateByKey状态函数、window窗口函数等,后续具体结合案例讲解。

http://spark.apache.org/docs/latest/streaming-programming-guide.html#transformations-on-dstreams

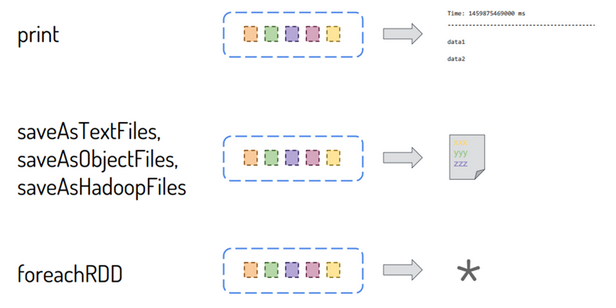

Output函数

Output Operations:将DStream中每批次RDD处理结果resultRDD输出

http://spark.apache.org/docs/latest/streaming-programming-guide.html#output-operations-on-dstreams

猜你喜欢:

AI智能应用开发(Java)

AI智能应用开发(Java) 鸿蒙应用开发

鸿蒙应用开发 HTML&JS+前端

HTML&JS+前端 Python+大数据开发

Python+大数据开发 人工智能开发

人工智能开发 跨境电商

跨境电商 电商视觉设计

电商视觉设计 软件测试

软件测试 新媒体+短视频

新媒体+短视频 集成电路应用开发

集成电路应用开发 C/C++

C/C++ 狂野架构师

狂野架构师 IP短视频

IP短视频